데이터 제약 환경에서도 활용 가능한 음성 AI 기술력 입증

텍스트 기반 LLM을 넘어 멀티 모달 LLM으로의 확장을 위한 기술적 발판 마련

에이아이트릭스(AITRICS, 대표 김광준)는 지난 6일부터 11일까지 인도 하이데라바드에서 개최된 세계 최대 규모의 음성·음향·신호처리 학술대회 'ICASSP(International Conference on Acoustics, Speech and Signal Processing) 2025'에서 총 2편의 논문이 채택됐다고 15일 밝혔다.

채택된 논문은 ▲운율 프롬프팅을 통한 안정적인 화자 적응형 텍스트-음성 합성(Stable-TTS: Stable Speaker-Adaptive Text-to-Speech Synthesis via Prosody Prompting)과 ▲얼굴 이미지 기반 제로샷 음성 합성 성능 향상을 위한 개선된 얼굴-음성 매핑 기법(Face-StyleSpeech: Enhancing Zero-shot Speech Synthesis from Face Images with Improved Face-to-Speech Mapping)이다. 에이아이트릭스는 두 편의 포스터 논문을 통해 고도화된 음성 AI 기술을 선보였다.

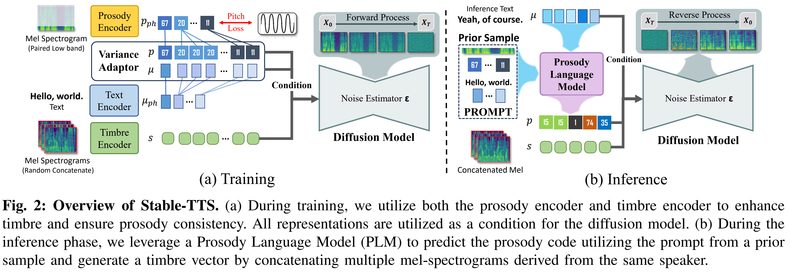

먼저, 첫 번째 논문에서는 소량의 음성 데이터로도 특정 화자의 말투와 억양을 자연스럽게 재현하는 화자 적응형 TTS(Stable-TTS) 프레임워크를 제안했다. 해당 모델은 기존의 화자 적응형 음성 합성 모델들이 가진 불안정한 음질 문제를 해결하고자 개발된 기술로, 제한적이고 노이즈가 섞인 환경에서도 안정적인 음성 합성이 가능하다.

화자 적응형 음성 합성 방식은 사전 학습에 사용된 고품질 음성 샘플을 운율 언어 모델(PLM, Prosody Language Model)과 사전 보존 학습에(Prior-preservation)에 활용해 안정적인 합성 능력을 유지한다. 이를 통해 한층 더 자연스럽고 안정적인 음성 생성이 가능하며, 음성 품질이 낮거나 샘플이 적더라도 자연스럽고 화자 유사도가 높은 음성을 생성하는 데 효과적임을 입증했다.

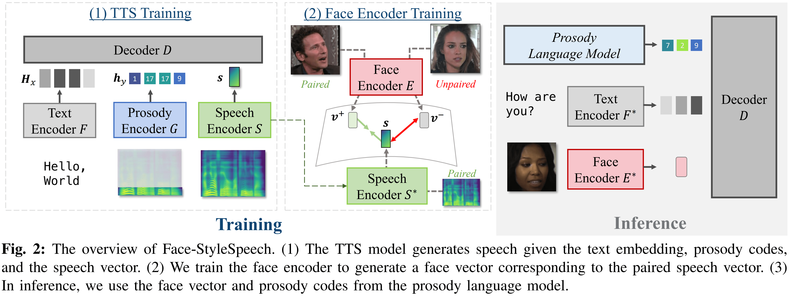

또한, 에이아이트릭스는 얼굴 이미지만을 기반으로 자연스러운 음성을 생성하는 제로샷 TTS 모델을 개발했다. 이 모델은 얼굴 이미지에서 유추할 수 있는 화자의 특성을 추출하고, 이를 운율 정보(Prosody Codes)와 결합하여 보다 사실적이고 자연스러운 음성을 생성한다. 특히, 기존 얼굴 기반 음성 합성 모델보다 더 정교하게 얼굴 정보와 음성 스타일을 매핑하여 음성의 자연스러움이 크게 향상됐다.

에이아이트릭스 한우석 연구원은 “이번 연구는 제한된 데이터만으로도 자연스럽고 안정적인 음성 생성이 가능함을 입증했다. 이는 실제 의료 환경처럼 데이터가 부족한 상황에서도 활용할 수 있을 것으로 기대된다”며 “이번 연구가 텍스트 기반 LLM(Large Language Model)을 넘어서 음성과 이미지를 결합한 멀티 모달 LLM으로 확장하기 위한 발판이라고 생각하며, 앞으로 지속적인 연구 개발을 통해 향상된 사용자 경험과 높은 신뢰도를 갖춘 의료 AI 서비스를 구현하기 위해 노력하겠다”고 전했다.

노영희 기자 nyh2152@medifonews.com

< 저작권자 © Medifonews , 무단전재 및 재배포금지 >

- 본 기사내용의 모든 저작권은 메디포뉴스에 있습니다.